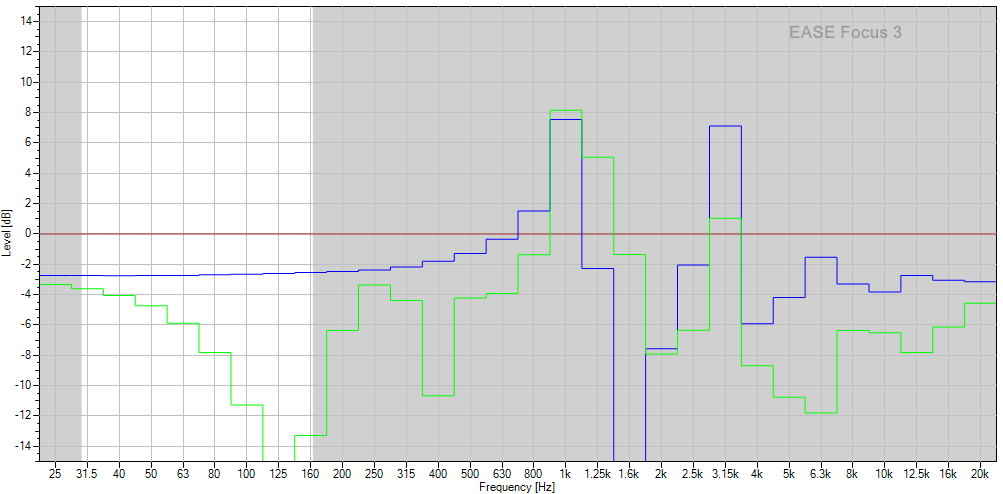

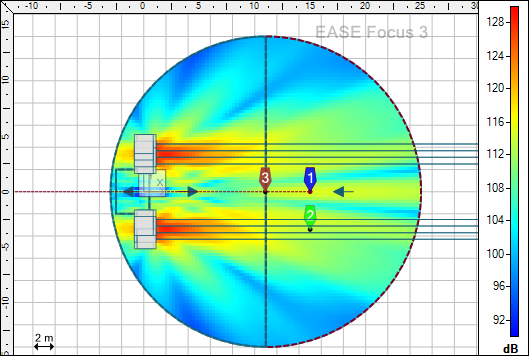

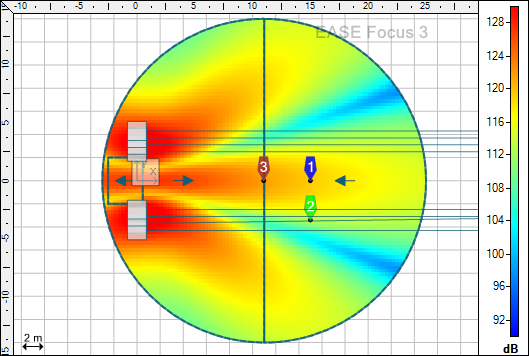

In questo articolo non mi soffermerò sui dettagli costruttivi dei pannelli fonoassorbenti e delle varie bass traps, di qualsiasi forma esse siano, in quanto la rete è piena di articoli e tutorial, ma piuttosto su un dettaglio che è emerso nel momento in cui, oltre ad usare i vari simulatori online o sottoforma di fogli di Excel disponibili in rete, ho provato la versione demo di AFMG SoundFlow; la società è nota anche per produrre EASE Focus 3, software di simulazione della dispersione di sorgenti sonore che si basa su file forniti dai produttori, e del quale si trovano alcune immagini in alcuni articoli già pubblicati su questo sito.

Detto questo, giusto per completezza, io stesso sto realizzando dei pannelli spessi 7cm dove ci sarà un foglio da 5cm di RockWool Acoustic 225 Plus e un “cuscino” d’aria di 2cm che, a seconda del tipo di montaggio, a muro, a soffitto e perché no anche a chiusura di un angolo come bass trap, può raggiungere un ingombro notevole. Questo modello di RoockWool ha una resistività al flusso d’aria pari a 25Kpas/m2, una densità di 70Kg/m3 ed inoltre ha una buona rigidità cosi da rimanere molto stabile all’interno della struttura in legno.

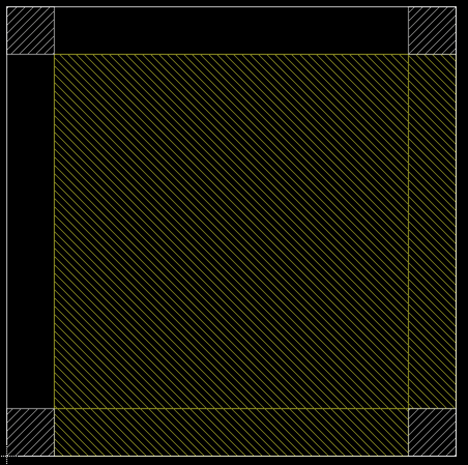

Ho in progetto inoltre di realizzare delle bass trap a forma quadrata con lato di 30cm sostenute dai classici listelli da 3cmX3cm o 4cmX4cm, cosi i lati verso l’ambiente potranno giovare di qualche centimetro un più di assorbente (3cm o 4cm) e quelli verso il muro ne avranno altrettanti come intercapedine d’aria; come assorbente acustico opterò tra uno dei seguenti:

- ISOVER ACUSTIPAR 4+ 13.5Kg/m3 7Kpas/m2

- ROCKWOOL PANNELLO 211 40Kg/m3 10/12Kpas/m2

- ISOVER UNI 40Kg/m3 12.3Kpas/m2

Veniamo quindi al dettaglio messo a disposizione da SoundFlow e alle varie implicazioni che questo ha nei calcoli e nei risultati simulati: la densità del materiale fonoassorbente. Che si tratti di lana di vetro, lana di roccia, lana minerale o qualsiasi altro materiale utile allo scopo, ognuno di essi ha una densità a parità di resistività al flusso dell’aria, e spesso anche a parità di densità i prodotti dello stesso tipo di diverse aziende hanno resistività differenti.

Nessun altro software di simulazione come ho scritto prima considera la densità del materiale nei vari calcoli, e questo può costituire una grossa differenza nel caso in cui la distanza dalla parete posteriore sia elevata oppure nel caso in cui lo spessore dello strato assorbente sia notevole, mentre ad esempio diventa praticamente trascurabile nel caso contrario.

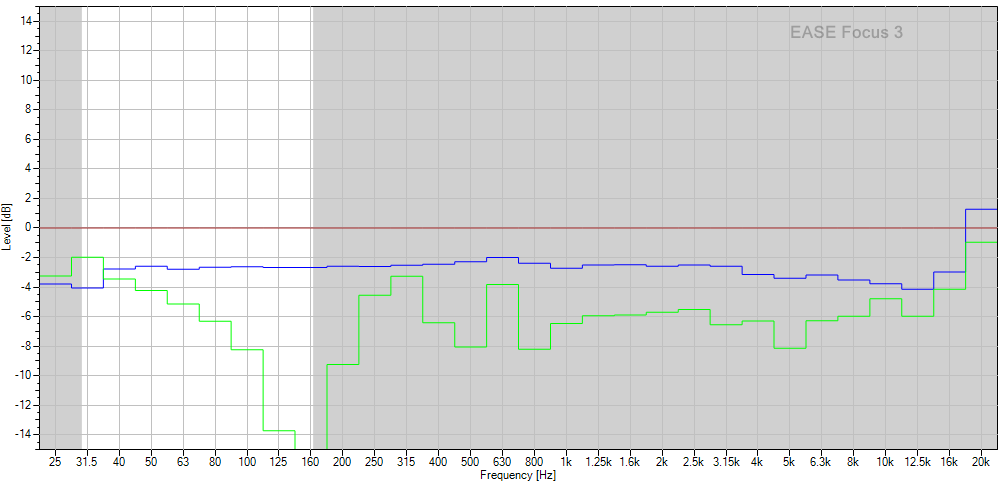

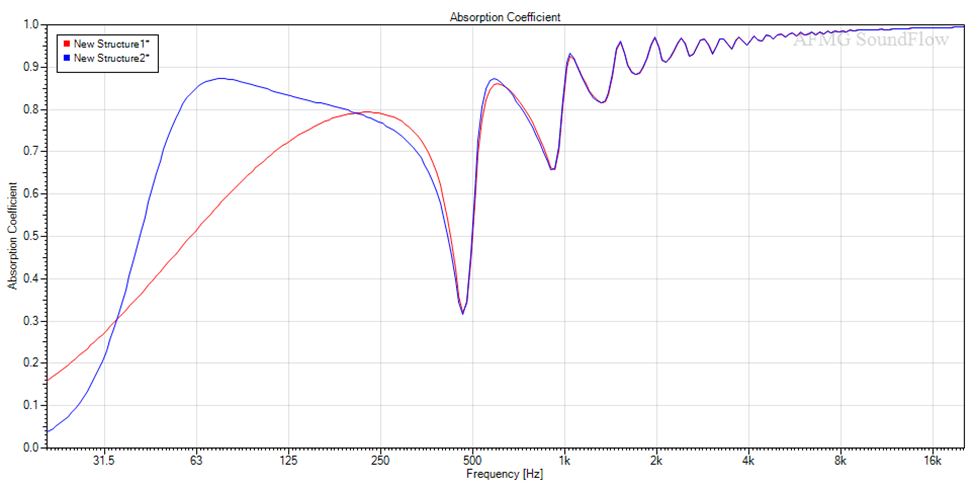

Vediamo alcuni esempi iniziando con il mio pannello, spesso 7cm di cui 5cm di materiale fonoassorbente da 27Kpas/m2 e 70Kg/m3.

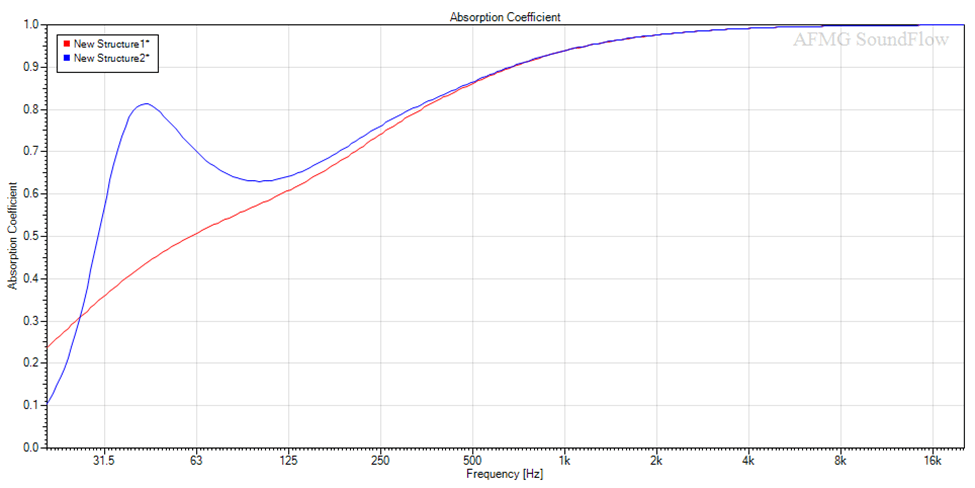

La curva blue rappresenta il mio caso, mentre quella rossa il classico calcolo senza considerare la densità, e come si può vedere la differenza è del tutto trascurabile (0,05 intorno ai 250Hz)

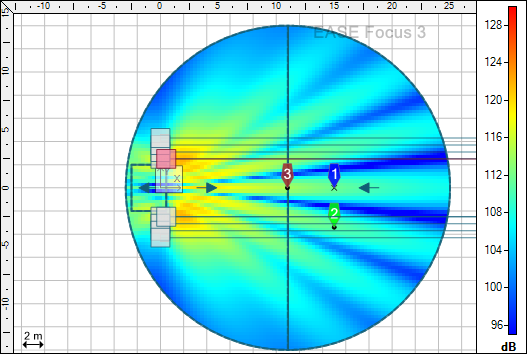

Se adesso ipotizziamo di posizionare questo pannello a chiusura di un angolo della stanza per farlo funzionare come se fosse una bass trap abbiamo che data la larghezza di 64cm (60cm il pannello + 4cm di legno) si ottiene una massima profondità dell’intercapedine d’aria pari a 34cm (32cm l’altezza del triangolo + 2cm del pannello), per cui l’immagine della simulazione diventa

Fino a circa 200Hz di nuovo le curve coincidono, ma poi la densità del materiale provoca una notevole differenza, arrivando a 63Hz ad avere un divario di circa 0,33 sul coefficiente di assorbimento.

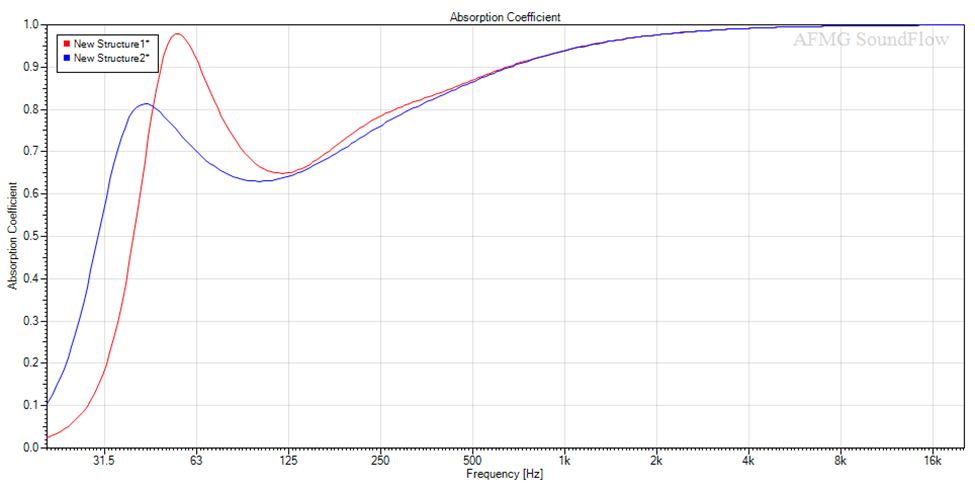

Considerando un materiale più leggero (rosso) si nota come alle frequenze più basse la banda si restringe, ma il coefficiente aumenta ulteriormente nella zona del picco; per contro si perde circa 0,17 intorno ai 40Hz.

Come detto 34cm rappresenta il massimo disponibile nella cavità dietro il pannello, che non avrà questa curva per ogni punto della sua superficie colpita dalle onde sonore, ma soltanto per una ristretta fascia verticale e per onde perpendicolari al pannello stesso.

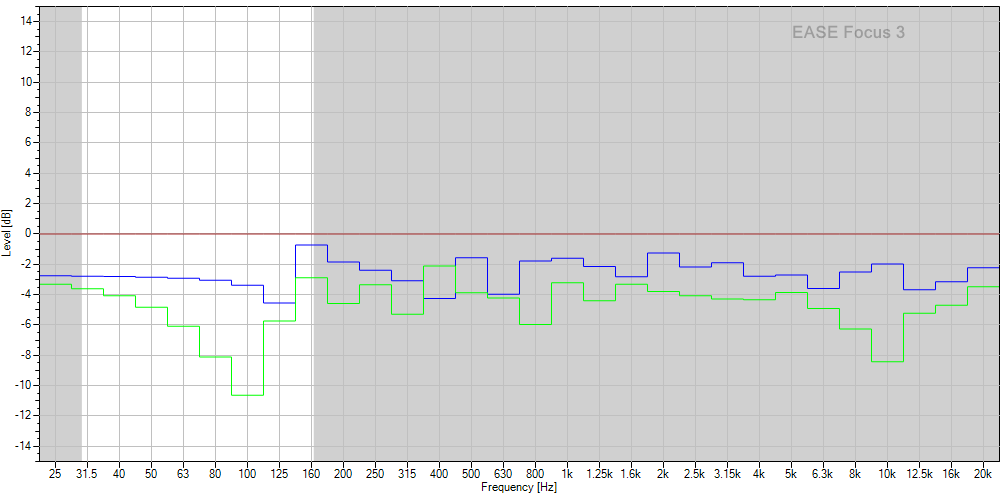

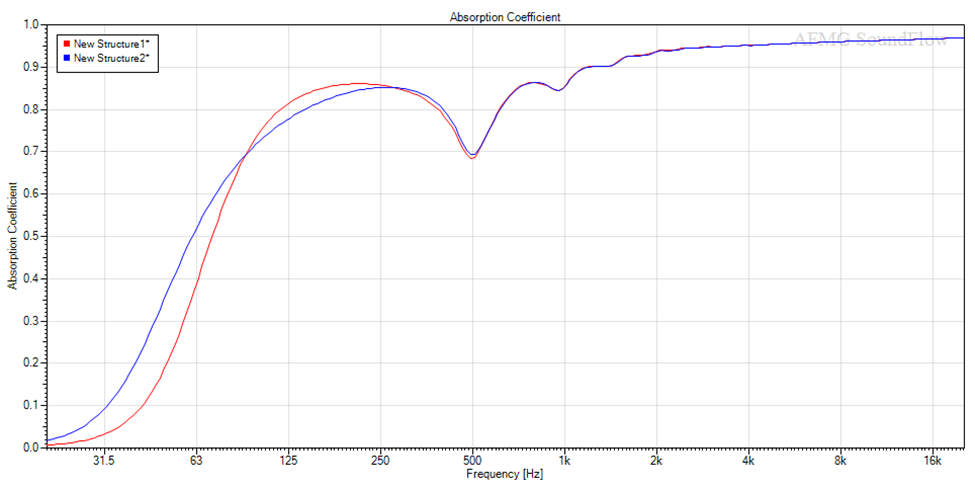

Ovviamente le onde non arrivano sul pannello tutte in modo perpendicolare, ma tendenzialmente in modo irregolare, e proprio in questo caso si parla di campo diffuso, che tra l’altro i vari software riescono a simulare, per cui le immagini precedenti diventano.

Con la linea rossa sempre senza considerare la densità del materiale, e

qui sopra con la linea rossa per un materiale più leggero.

Di nuovo una sostanziale sovrapposizione fino a 250Hz, ma poi invece dei circa 0,33 di differenza a 63Hz rispetto al caso precedente qui abbiamo 0,14 e su un valore molto più basso, sebbene ci sia un rispettabile 0,52 come coefficiente di assorbimento con il materiale più denso.

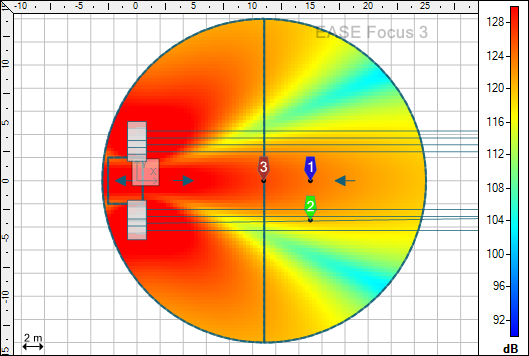

Vediamo ora cosa succedere con una bass trap realizzata con pezzi da 30cm X 30cm di isolante disposti uno sopra l’altro fino ad arrivare all’altezza desiderata, e sostenuta lateralmente diciamo dai soliti listelli 4cm x 4cm; in questo modo, come scritto sopra, nei due lati che guardano il muro possiamo lasciare un’intercapedine d’aria di pari spessore e sui due lati verso l’ambiente possiamo sfruttare ulteriori 4cm da riempire, arrivando così ad una profondità totale di 34cm. Una cosa del genere vista in sezione, dall’alto

Ipotizzando di usare del materiale con una resistività pari a 12Kpsa/m2 abbiamo di nuovo una sostanziale sovrapposizione fino a 250Hz e anche meno, ma poi la curva blue (che tiene conto della densità di 40Kg/m3) inizia a discostarsi dall’altra fino ad arrivare al picco di assorbimento intorno ai 40Hz per poi calare, mantenendo comunque 0,55 come coefficiente a 31Hz; quella rossa (densità = 0) procede invece nella sua discesa regolare.

Con una densità differente invece, 40Kg/m3 per il grafico blue e 20Kg/m3 per quello rosso otteniamo

Ovviamente per effetto della minore densità il picco di assorbimento si sposta in alto e con valori maggiori, ma su un intervallo di frequenze più ristretto.

Questo per quanto riguarda il caso di “impatto” perpendicolare delle onde sui due lati della bass trap, mentre nel caso di campo diffuso, più realistico, si ottiene rispettivamente

con la linea rossa che simula una densità = 0, e

con la linea rossa per una densità dimezzata rispetto a quella blue

Quindi la densità del fonoassorbente:

- È ininfluente sul risultato finale nel caso di spessori ridotti e intercapedini d’aria

- Fa differenza nel caso di elevati spessori, già ad esempio con 16/20cm di alcuni pannelli considerati bass trap

- È da considerare nel caso di spessori ridotti di materiale e elevate intercapedini d’aria (pannello messo ad angolo) e comunque non pari a 0

Questo almeno quello che riporta la simulazione; se qualcuno ha esperienze “dirette” in merito, anche supportate da misure che possano confermare queste simulazioni sarebbe molto interessante.